Inhaltsverzeichnis

1. AI-Inferenz im Embedded-Endpunkt

2. Fokus auf Inferenz

3. e-AI – Ergebnis umfassender F&E-Aktivitäten

4. Welche speziellen Vorteile bietet die Lösung?

5. Softwarewerkzeuge und Schnittstellen bleiben unverändert

6. Spezialisiert auf Embedded-AI am Endpunkt

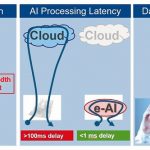

Für den Trend, die AI-Verarbeitung von zentralisierten Cloud-Verarbeitungsplattformen auf den Endpunkt zu verlagern, gibt es viele Gründe. Erstens begrenzen Bandbreiteneinschränkungen die Fähigkeit, die benötigten Daten vom Beobachtungspunkt an eine Cloud zwecks Durchführung der entsprechenden Analysefunktionen bereitzustellen. Bei vielen Geräten und Maschinen gibt es womöglich gar keine Verbindung zum Internet. Ausschlaggebend mögen hierfür Einschränkungen der Infrastruktur oder Bedenken in puncto Datenschutz sein. Dennoch möchte man die vielen Vorteile aus dem Einsatz von AI-Technologien nutzen, um die Leistung eines Produktes oder die Gesamteffizienz einer Anlage zu verbessern.

Zweitens, selbst wenn eine Verbindung zur Cloud mit ausreichend Bandbreite zur Verfügung steht, müssen viele AI-Anwendungen Daten in Echtzeit – innerhalb von Milli- oder Mikrosekunden – verarbeiten. Das ist mit heutiger Connectivity-Technologie nicht machbar. Eine Cloud-Verbindung ist unzuverlässig oder nicht-deterministisch in Bezug auf die Latenz und führt zu mehr als einigen Dutzend Millisekunden Verzögerung.

Drittens ist die Vertraulichkeit der Daten ein weiterer Grund, die Analysefunktionen nicht in der Cloud sondern im Embedded-Endpunkt auszuführen. Viele Industriesektoren betrachten die verarbeiteten Daten selbst schon als proprietär und sind vorsichtig, diese Daten außerhalb ihres eigenen Netzwerkes zu teilen. So sammeln beispielsweise medizinische Geräte persönliche Daten über den Gesundheitszustand eines Patienten, wobei die Weitergabe dieser Daten stark eingeschränkt werden muss. In der Industrieautomatisierung zeigen die analysierten Daten, wie Prozesse in einem Werk gesteuert werden und gelten daher als grundlegendes Wissen des produzierenden Unternehmens. Und schließlich ergeben sich auch aus Datenschutzbestimmungen viele Beschränkungen für die Speicherung und Verarbeitung von Endanwenderdaten.

AI-Inferenz im Embedded-Endpunkt

Zu den weiteren Vorteilen der Verarbeitung am Endpunkt gehört die Möglichkeit, hierarchische, vernetzte AI-Systeme zu erstellen, die robust und skalierbar sind, während sie sich zugleich mit Blick auf Leistung und Energieverbrauch für einen speziellen Anwendungsfall optimieren lassen.

Diese Herausforderungen verdeutlichen die Notwendigkeit einer effizienten AI-Inferenz im Embedded-Endpunkt. Erforderlich sind also effiziente Endpunkte, die in Echtzeit Daten vorverarbeiten, analysieren und filtern können. All dies dient zur Optimierung der Geräteleistung und zur Analyse der entsprechenden anwendungsspezifischen Datenpunkte direkt im Endpunkt, wobei alle zuvor erwähnten Einschränkungen vermieden werden. Dies ist der Kern der e-AI-Lösungen von Renesas.

Ein gängiges Ziel von KI/AI ist die Verbesserung der Anlagengesamteffizienz. Dabei geht es um die Maximierung der Verfügbarkeit, Leistung und Produktionsausbeute. Mit e-AI-Methoden lassen sich Maßnahmen zur prädiktiven Wartung implementieren. Diese analysieren kontinuierlich den Betrieb und Zustand eines Geräts, um nötige Wartungsmaßnahmen zu melden, noch bevor die Geräteleistung beeinträchtigt ist. Mit solchen Analysefunktionen lässt sich der Wartungszeitpunkt für Geräte oder eine bestimmte Maschine individuell optimieren. Dies ermöglicht einen dynamischen, individuellen Wartungsplan, der wesentlich kosteneffizienter ist als ein Vorgehen nach einem statischen Wartungsplan.

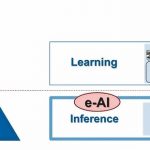

Fokus auf Inferenz

Es ist wichtig zu verstehen, dass e-AI-Verarbeitung in der Regel Inferenz-Verarbeitung bedeutet. Der Begriff Inferenz beschreibt in der AI-Terminologie den Prozess der Analyse von erfassten Daten mit Hilfe eines gelernten AI-Modells. Die Nutzung eines gelernten Modells für eine bestimmte Aufgabe ist bei Embedded-Anwendungen der typische, generische Anwendungsfall. Im Gegensatz dazu bezeichnet man die Erstellung eines Modells als Training (oder Lernen), was ein ganz anderes Maß an Rechenleistung erfordert. Das Training erfolgt daher in der Regel auf Hochleistungs-Recheneinheiten, die oft über Cloud-Dienste bereitgestellt werden. Je nach Komplexität des Modells kann das Training eines Modells Minuten, Stunden, Wochen oder sogar Monate dauern. e-AI-Verarbeitung übernimmt in der Regel keine derartigen Modellerstellungsaufgaben. e-AI trägt stattdessen mit Hilfe von gelernten Modellen zur Verbesserung der Geräteleistung bei. Nutzt man die durch die schnell wachsende Anzahl von Sensoren erzeugten Daten, dann kann e-AI gewährleisten, dass Geräte im idealen Betriebszustand arbeiten, und zwar gleichgültig, ob es sich um einen Industrieantrieb, eine Waschmaschine oder einen Schrittzähler handelt. Genau hierauf konzentriert sich Renesas: auf die Intelligenz im Endpunkt.

e-AI – Ergebnis umfassender F&E-Aktivitäten

Als führender Halbleiterhersteller hat Renesas solche Mechanismen in seinen Werken implementiert. Die aus diesen Maßnahmen entwickelten Technologien teilt das Unternehmen nun mit seinen Kunden, sodass auch diese von den Vorteilen dieser Technologie profitieren können. Das heißt: Renesas hat Algorithmen zur Erkennung von Anomalien sowie für prädiktive Wartung auf der Basis von neuronalen Netzwerk-Architekturen implementiert und damit die Leistung der Plasmaätzmaschinen in seinem Werk im japanischen Naka optimiert. Die Ergebnisse dieser Arbeit waren so überzeugend, dass weitere Machbarkeitsnachweise bei verschiedenen Kunden und Partnerunternehmen implementiert wurden.

So nutzt beispielsweise die Hino Factory von GE Healthcare in Japan eine auf der e-AI-Technologie beruhende AI-Einheit, um die Produktivität zu verbessern. Das Renesas-Partnerunternehmen Advantech liefert eine solche AI-Einheit als einfache Nachrüst-Option, um e-AI-Technologien in bestehende Maschinen oder Geräte zu implementieren.

Welche speziellen Vorteile bietet die Lösung?

Ein Fokus liegt auf dem geringen MCU/MPU-Stromverbrauch. Bringt man die AI-Verarbeitung an den Endpunkt, dann gewinnt das Verhältnis zwischen Stromverbrauch und Rechenleistung zentrale Bedeutung. Oft überschreitet eine handelsübliche Grafikkarte oder ein Smartphone-Beschleuniger die Stromverbrauchs- und Größenbeschränkungen industrieller Anwendungen um ein Vielfaches. Darüber hinaus müssen heutige Lösungen auf einem Plattform-Konzept basieren und sich entsprechend den Anforderungen der Anwendungen skalieren lassen. Grundlegende Algorithmen können daher über die Software eines Mikrocontrollers verarbeitet werden. Andere benötigen hingegen einfache Hardware-Beschleuniger. Nochmals andere Algorithmen erfordern erhebliche Hardwarebeschleunigung, um ihre Leistungsziele zu erfüllen.

Zur Abdeckung einer großen Bandbreite unterschiedlicher Leistungsziele hat Renesas ein dynamisch rekonfigurierbares Prozessormodul (Dynamically Reconfigurable Processor – DRP) entwickelt, mit dem sich Ressourcen zur Beschleunigung von e-AI-Aufgaben flexibel zuweisen lassen. Der DRP nutzt in großem Umfang Parallelverarbeitung, um die Anforderungen moderner AI-Algorithmen zu erfüllen. Da das DRP-Design für geringen Stromverbrauch optimiert ist, eignet es sich für viele Einsatzbereiche von kundenspezifisch angepassten Algorithmen mit schneller Inferenz. Damit passt es zu den meisten Anforderungen von Embedded-Endpunkten. Der DRP von Renesas ermöglicht hohe Rechenleistung bei geringem Energiebedarf, was ihn für Embedded-Anwendungen prädestiniert. Der DRP lässt sich dynamisch rekonfigurieren und damit an verschiedene Anwendungsfälle und/oder Algorithmen in der gleichen Hardware anpassen.

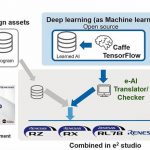

Softwarewerkzeuge und Schnittstellen bleiben unverändert

Erfreulicherweise bleiben unabhängig von dem Maß an Beschleunigung die Softwarewerkzeuge und Schnittstellen unverändert. Für das Lernen liefert Renesas keine eigenen Frameworks, stellt jedoch Tools zur Übersetzung der neuronalen Netzwerkmodelle in einem Format bereit, das sich auf Renesas MCUs und MPUs ausführen lässt. Der Translator übersetzt neuronale Netzwerkmodelle aus gängigen Trainings-Frameworks wie Google TensorFlow. Diese Frameworks kommen meist für das Training eines neuronalen Netzwerkmodells zum Einsatz. Die Inferenz wird dann auf den Renesas MCU/MPU-Bausteinen ausgeführt, indem der Output aus dem Translator-Tool in das entsprechende Programm einfach eingebettet wird.

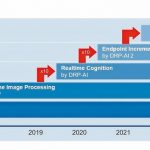

Die Renesas e-AI/DRP-Roadmap enthält vier Leistungsklassen, wobei jede Klasse jeweils die zehnfache Leistung für die Berechnung von Neuronalen Netzen bietet als die vorherige Klasse. Dank seiner besonderen Positionierung bei der Endpunkt-Inferenz zusammen mit führender MCU/MPU-Technologie bietet das Unternehmen seinen Kunden ein gutes Verhältnis von Energiebedarf zu Rechenleistung für die AI-Verarbeitung.

Spezialisiert auf Embedded-AI am Endpunkt

Dank seines flexiblen und skalierbaren e-AI-Konzepts bietet der Halbleiter-Hersteller eine zukunftssichere, energieeffiziente Echtzeit-AI-Verarbeitungslösung, die sich für die besonderen Anforderungen der künstlichen Intelligenz in Embedded-Geräten am Endpunkt eignet. ge

Weitere Informationen auf der e-AI-Website

Messe SPS IPC Drives 2018: Halle 10.1, Stand 130