Eine sich an sich verändernde Randbedingungen selbstständig anpassende Produktion verlangt neben einem umfangreichen Prozess-Know-how eine wesentlich leistungsfähigere Sensorik. Interne Signalverarbeitung und Multisensorsysteme sind dabei zwei entscheidende Entwicklungsschritte hin zu einer Sensorik für die Industrie 4.0, mit der sich aus den immensen Datenmengen verwertbare Informationen gewinnen lassen. Der Lohn ist eine Prozess-Kontrolle in Echtzeit – mit der Möglichkeit zur direkten Optimierung.

Die Autoren Dies ist eine Zusammenfassung des Vortrags ‚3.2: Sensoren für die digitale Produktion‘, gehalten anlässlich des Aachener Werkzeugmaschinen-Kolloquiums im Mai 2014. Mitarbeiter der Arbeitsgruppe für diesen Vortrag waren: Prof. Dr.-Ing. Dr.-Ing. E.h. Dr. h.c. Dr. h. c. F. Klocke, WZL RWTH, Aachen Prof. Dr. Yvonne Joseph, ESM TU Freiberg, Freiberg Prof.-Dr.-Ing. A. Trächtler, Heinz Nixdorf Institut, Paderborn M. Backmeyer, National Instruments, Petersberg M. Blattner, Kistler Instrumente AG, Winterthur, Schweiz Dr.-Ing. G. Eisenblätter, Heidelberger Druckmaschinen AG, Wiesloch Ch. Henke, Heinz Nixdorf Institut, Paderborn R. Jamal, National Instruments, München Dr.-Ing. Drazen Veselovac, WZL RWTH, Aachen

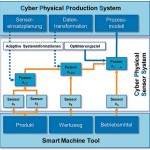

Mit der weiteren Digitalisierung der Produktion und der Vernetzung von Maschinen und Werkzeugsystemen mit Betriebsmitteln und innerbetrieblichem Materialfluss entstehen Cyber-Physical Production Systems (CPPS). Deren Intelligenz und Leistungsfähigkeit basiert wesentlich auf der Verfügbarkeit von realen Prozessdaten – was leistungsfähige und resiliente (gegenüber Störungen tolerante) Sensoriken voraussetzt. Die heute im produktionstechnischen Umfeld zum Einsatz kommende Sensorik besitzt dagegen zwei Schwachstellen:

- Einfache Messsignale einer Messgröße lassen sich ohne eine Kombination mit anderen Messgrößen nicht interpretieren. So führt beispielsweise die Auswertung der Signale eines Kraftsensors zur Erfassung von Prozesskräften ohne die Information über die Position von Werkstück und Werkzeug zu einer Fehlinterpretation.

- Viele Problemstellungen sind über eine einfache Signalauswertung nicht zielführend bedienbar. Die Sensoren können zwar eine Messgröße erfassen, liefern zur Überwachung des Prozesses aber ohne eine erweiterte Signalverarbeitung keinen Mehrwert. Diese erlaubt eine modellbasierte Interpretation der erzeugten Qualitäten oder der Zustände von Werkzeug, Maschine und Hilfsmittel.

Abhilfe verspricht hier die Entwicklung von Multisensorsystemen und die Integration einer intelligenten Signalverarbeitung in die Sensoren (Bild 2). Einerseits werden dazu integrierte Sensoren entwickelt, welche einen höheren Informationsgehalt liefern sollen. Diese Sensoren erlauben bereits eine Auswertung der aufgenommenen Daten und liefern auf diese Weise durch die Anwendung geeigneter Modelle bereits Informationen anstatt einfacher Signale an die nächste Instanz (Steuerung der Maschine – und damit an den Bediener oder an die Prozessplanungsebene). Anderseits werden Multisensorsysteme entwickelt, welche die Erfassung mehrerer Größen in einem System ermöglichen. Hierbei handelt es sich um Netzwerke von Sensoren oder integrierte Lösungen, welche die Messung von mehreren Messgrößen über ein Sensorsystem erlauben. Eine Rolle werden dabei auch die Miniaturisierung und die Autarkie der Sensorsysteme spielen. Im Rahmen der Autarkie kann etwa durch die Gewinnung der erforderlichen Energie aus der Umgebung zusammen mit der drahtlosen Kommunikation eine komplett kabellose Sensorlösung angestrebt werden.

Multisensorsystem für die 5-Achs-Bearbeitung

In welche Richtung sich die Sensorik entwickelt, zeigt exemplarisch ein Multisensorsystem zur Kraftmessung zur Kompensation von Störeffekten bei der 5-Achs-Bearbeitung. In der Zerspanung ist die Messung von Prozesskräften essenziell für die Prozessanalyse und -optimierung. Dazu wird in den meisten Fällen die piezoelektrische Kraftmessung genutzt, bei der einzelne Quarzscheiben vorgespannt und zu einem Sensor mit hoher Linearität zusammengefügt werden. Bei genauer Betrachtung des Bearbeitungsprozesses lassen sich allerdings zahlreiche Stör- und Umgebungseinflüsse erkennen, die ein Multisensorsystem idealerweise ebenfalls erfassen und berücksichtigen sollte. Dazu zählen unter anderem

- die Einsatztemperatur, die eine Veränderung des Zusammenhangs zwischen der Kraft und der durch den Sensor abgegebenen Ladung bewirkt,

- dynamische Effekte, die bei der Messung von Zerspankräften zu einer Verfälschung der Messgröße führen (insbesondere beim Fräsen wird das Werkstück durch das Ein- und Austreten der Schneiden zu Schwingungen angeregt) und

- zusätzlich zur Prozesskraft wirkende statische und dynamische Kräfte aufgrund der Bewegung von Werkstück und Kraftmessplattform im Raum.

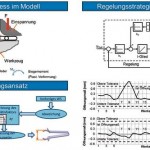

Die reine Kraftmessung bei der 5-Achs-Bearbeitung würde deshalb zu Fehlinterpretationen führen. Erst durch die kombinierte Auswertung verschiedener Sensoren besteht die Möglichkeit, die Störgrößen zu erfassen und den Informationsgehalt der Messung zu steigern. Für die Erfassung von Prozesskräften im Zuge der digitalen Produktion ist zudem neben der drahtlosen Datenübertragung (um eine freie Bewegung des Messsystems in allen Bearbeitungsrichtungen zu erlauben) eine weitere Einbettung von Sensoren und Datenvorverarbeitung in die eigentliche Kraftmessplattform anzustreben. Die Erfassung von Position und Beschleunigung des Werkstücks wird etwa über Beschleunigungssensoren und miniaturisierte Lagesensoren realisiert, wie sie in Smartphones bereits verwendet werden. Um die Datenübertragungsraten gering zu halten, muss eine Vorverarbeitung auf dem System (sensorintegrierte Signalverarbeitung) stattfinden. Hierzu werden rekonfigurierbare Datenerfassungssysteme verwendet. Diese erlauben – je nach Anwendungsfall! – eine veränderte Datenverarbeitung auf dem System. Für die Prozessüberwachung oder Prozessregelung werden vom System dann nur noch die notwendigen Kennwerte übertragen. Durch die Rekonfigurierbarkeit kann die Verrechnungsmethode jederzeit optimal an die jeweiligen Anforderungen angepasst werden (Bild 3).

Integrierte Signalverarbeitung mit Zellularen Neuronalen Netzwerken

Ein interessantes Beispiel für die sensorintegrierte Signalverarbeitung mit neuartigen Kamerasystemen ist die Schmelzbadüberwachung beim Laserschweißen. Ermöglicht wird das durch Zellulare Neuronale Netzwerke (CNN). Die Besonderheit dieser Systeme besteht darin, dass jedes einzelne Pixel des optischen Sensors mit einer eigenen Einheit zur Datenverarbeitung und Speicherung verbunden ist. Zusammen bilden diese Komponenten jeweils eine Zelle. Dieser Aufbau ermöglicht die parallele Verarbeitung der Daten sämtlicher Bildpunkte. Die einzelnen Zellen des Sensorsystems sind zudem mit den jeweils unmittelbar benachbarten Zellen verbunden. Hierdurch entsteht ein Netzwerk einzeln verarbeitender Elemente.

Die interzellularen Verbindungen führen dazu, dass die Zellen nicht nur die Daten eines einzelnen Pixels verarbeiten, sondern gleichzeitig miteinander interagieren können. Dieser Aufbau ist an das Vorbild natürlicher neuronaler Netzwerke angelehnt, wobei die einzelnen Zellen des CNN biologischen Nervenzellen nachempfunden sind [2]. Unter Vorgabe geeigneter Algorithmen ermöglicht die CNN-Architektur die besonders schnelle Verarbeitung von Bilddaten. Der zellulare Aufbau des Systems führt jedoch dazu, dass die verarbeiteten Daten abermals in Bildform ausgegeben werden. In entsprechenden Kamerasystemen wird deshalb der CNN-basierte Prozessor in Fokalebene durch ein nachgeschaltetes FPGA (Field Programmable Gate Array) ergänzt. Dieses steuert den Fokalprozessor und interpretiert die ausgegebenen Daten. Da die Daten bereits in vorverarbeiteter Form vorliegen, ist durch den FPGA-Prozessor eine wesentlich geringerer Rechenleistung aufzubringen, als dies bei einer direkten Auswertung der Bilddaten der Fall wäre. Insgesamt befähigt dieser Aufbau somit das System zu einer internen Datenverarbeitung bei sehr hohen Verarbeitungsgeschwindigkeiten, wobei Bildraten von mehr als 10.000 fps erreicht werden können [3] und das Ergebnis der Auswertung direkt als Regelungs- oder Steuersignal ausgegeben werden kann. Die aufgenommenen Bilddaten müssen also zur weiteren Auswertung nicht an einen Messrechner übertragen werden – was allerdings nachteilig ist, wenn die Speicherung der Bilddaten etwa zu Dokumentationszwecken ausdrücklich gefordert wird.

Aufgrund der dargestellten Vorteile besitzen CNN-Kamerasysteme eine hohe Eignung zur Verwendung in den Bereichen der Echtzeit-Überwachung und der Echtzeit-Regelung. Abt et al. realisierten beispielsweise eine Echtzeit-Regelung eines Laserstrahltiefschweißverfahrens für überlappende Bleche [4]. Der Prozess wird in diesem Fall koaxial durch die Laserschweißoptik mit Hilfe eines CNN-basierten Kamerasystems überwacht. Durch Überwachung und Analyse der für den Tiefschweißprozess typischen Dampfkapillare und des umgebenden Schmelzbads ermöglicht das Kamerasystem, den aktuellen Prozesszustand zu ermitteln.

Multisensorsystem als Lab-on-a-Chip

Die Überwachung von Prozessen und Maschinen in der Produktionstechnik basiert heute auf der Erfassung physikalischer Kenngrößen – die Überwachung oder sogar Regelung von Hilfsstoffen erfolgt kaum. Durch eine ständige und intensive Kontrolle kann allerdings die Verlängerung der Lebensdauer und das Einhalten der geforderten Eigenschaften von Kühlschmierstoffen, Elektrolyten und Dielektrika realisiert werden – was insbesondere die Entwicklung von chemischen Sensoren erfordert, die in flüssigen oder gasförmigen Phasen im laufenden Fertigungsprozess chemische Kennwerte ermitteln können. Ähnlich wie Biosensoren weisen chemische Sensoren eine Rezeptivität für die zu analysierenden Stoffe auf. Die Bindung zwischen Analyt und sensitiver Schicht muss reversibel sein, um eine fortwährende Analyse zu gewährleisten. Die Struktur eines chemischen Sensors ist dabei nicht nur exakt auf einen Analyten ausgerichtet, sondern ermöglicht die Bindung von verschiedenen Analyten. Über einen Messwandler kann die chemische Messgröße elektrisch erfasst werden.

Um beispielsweise in Kühlschmierstoffanlagen schnell und gezielt vor Ort – und im Prozess! – notwendige Anpassungen vornehmen zu können, lassen sich zur Charakterisierung des Zustandes der Kühlschmierstoffe mehrere Einzelsensoren zu einem Sensor-Array zusammenfügen, einem Lab-on-a-Chip (Bild 4). Die Sensitivität für mehrere Analyte erfordert dabei eine intelligente Auswertung der Sensorsignale. Hierbei ist es wiederum mit Hilfe von künstlichen neuronalen Netzwerken möglich, einen kausalen Zusammenhang zwischen den Sensordaten und spezifischen chemischen Kenngrößen herzustellen. Kühlschmierstoffe lassen sich auf diese Weise länger nutzen und durch die kontinuierliche Analyse kann das Entstehen toxischer Substanzen frühzeitig durch Zugabe von exakt dosierten Additiven wirkungsvoll verhindert werden.

Mit Sensoren die digitale Produktion gestalten

Die Möglichkeiten der Vernetzung und vielfachen Verwendung von Prozessdaten werden heute unter dem Begriff Cyber-Physical Production System diskutiert. Grundlage ist ein Cyber-Physical Sensor System (CPSS), das die Vernetzung von mehreren Sensoren per selbstständiger Fusion beschreibt (Bild 5). Die Grundlage für die Vernetzung bilden adaptive Systeminformationen, welche von dem CPPS an das Sensorsystem gegeben werden. Unter Berücksichtigung von Optimierungszielen liefern die CPSS die Prozessinformationen an das CPPS, welche zum Aufbau von geeigneten Prozessmodellen benötigt werden.

Um den Prozess oder einzelne Bauteileigenschaften selbstständig zu überwachen, müssen aus den Rohdaten Informationen extrahiert werden. Die dafür verwendeten Algorithmen müssen im CPPS dynamisch an das jeweilige Bauteilfeature angepasst werden. Um diese Adaptivität zu erreichen, werden Informationen aus der Planungsebene benötigt, die von PLM-Systemen zur Verfügung gestellt werden können. Die Konfiguration einer zukünftigen Prozessüberwachung erfolgt über die Fertigungsplanung. Die Optimierungskriterien beziehungsweise nicht zu über- oder unterschreitenden Grenzkriterien (etwa Stabilitätskenngrößen, minimale Spanungsdicken, …) können entweder durch Kennwerte hinterlegt sein oder aus Modellierungen in den CAx-Systemen ermittelt werden. Wenn kennwertbasiert gearbeitet werden kann – was insbesondere für KMUs eine wichtige Option darstellt –, verringern sich das Datenvolumen und die benötigte Rechnerleistung erheblich. Im Extremfall können Kennwerte ausschließlich über Attribute wie ‚gut‘ oder ‚schlecht‘ beschrieben werden.

Die steigende Messgenauigkeit von Sensoren bei gleichzeitig höherer zeitlicher Auflösung stellt für die Verarbeitung der Daten eine Herausforderung dar. Limitierende Faktoren sind dabei die Übertragungsrate und Latenzzeit heutiger Bussysteme in Werkzeugmaschinen. Durch die Bereitstellung der Informationen auf verschiedenen Ausführungsebenen wandeln sich deshalb auch die Anforderungen zur Echtzeitverarbeitung. Für harte Echtzeitanforderungen werden zukünftige Sensorsysteme die Verarbeitung der Daten zu Informationen eigenständig erledigen müssen. Die bereitgestellten Informationen können dann Aktor-Komponenten oder einem höheren Zielsystem für die weitere Verarbeitung zur Verfügung gestellt werden. Berechnete Kennwerte können bei nicht-zeitkritischen Applikationen über Standard-Netzwerkprotokolle zu Datenbanksystemen übertragen werden. Auch einen direkten Stream von Daten auf einen dezentralen Datenspeicher könnte ein CPPS-Sensor ohne Host verarbeiten.

Skalier- und Rekonfigurierbarkeit

Um eine möglichst hohe Flexibilität zu gewährleisten, müssen verstärkt rekonfigurierbare und skalierbare Systeme auf Basis von Realtime-Prozessoren und FPGA-Technologie zum Einsatz kommen. Hersteller von Sensoren und Aktoren können in Bezug auf CPPS nur eine Hardwareplattform zur Verfügung stellen, da die Anforderungen kundenseitig stark variieren. Daher sollte die Entwicklung offener, leicht integrierbarer Embedded-Sensorplattformen das Ziel sein. Anwender können damit Messgeräte und Aktoren durch eigene Algorithmen um neue Funktionen erweitern. Die Forderung der Kunden nach intelligenten Produkten, die flexibel erweiterbar sind, zeigt sich schon heute in vielen Bereichen der Unterhaltungsindustrie. Diese intelligenten Geräte lassen sich über ‚Tech-Apps‘ an die jeweiligen Kundenbedürfnisse anpassen. Eine Vielzahl dieser Plattformen erlaubt auch die eigene Programmierung von Apps durch den Anwender. Diese Anwendungen können dann verkauft oder kostenlos der Community zur Verfügung gestellt werden. Zukünftige Geräte sind deshalb offene, rekonfigurierbare und vom Kunden anpassbare Plattformen, die zur Bildung von Communities führen. Diese Anwendergemeinschaften generieren durch die Entwicklung von Apps neue Anwendungsgebiete und Funktionen für die verschiedenen Hersteller.

Die größte Herausforderung bei der Vernetzung stellt die Verwaltung der erzeugten Daten und Informationen dar. Der Technologieausblick 2013 von National Instruments zur Datenerfassung [5] beschreibt diese Herausforderung mit den Worten: „Es ist nicht mehr entscheidend, wer die meisten Daten sammelt, sondern wer die gesammelten Daten schnell sinnvoll nutzen kann.“ Versuchs- und Produktionsdaten beinhalten meist sehr wertvolle und wichtige Informationen zur Beurteilung eines Prozesses oder Produktes. Ein Verlust dieser Daten durch unzureichende Protokollierung führt zwangsläufig zu hohen Kosten. Ohne diese Versuchsdaten können wirtschaftliche Entscheidungen insbesondere bei der Auslegung von neuen Prozessen nicht gefällt werden.

Für das schnelle Auffinden und zur sicheren Dokumentation ist es daher notwendig, beschreibende Zusatzinformationen mit den Messdaten abzulegen. Einige standardisierte Datenformate bieten hier eine ideale Datenstruktur, die es ermöglicht, mit kommerziellen Systemen schnelle und kostengünstige Datenmanagement-Systeme aufzubauen, ohne auf die klassischen Funktionalitäten einer Datenbank zu verzichten. Da der Zugriff auf Messdaten, Informationen und Kennwerte zukünftig auch außerhalb der Unternehmen geschehen muss, wird an der Entwicklung der ‚Technical Data Cloud‘ gearbeitet. Dabei werden – dynamisch an den Bedarf angepasst – IT-Infrastrukturen, Rechenkapazität, Datenspeicher, Netzwerkkapazitäten oder Services zur Verfügung gestellt [10] (Bild 6). Der Vorteil für Unternehmen ist, dass kurzfristig benötigte Ressourcen nicht zu einem irreversiblen, kostenintensiven Ausbau der IT-Infrastruktur führen.

Fernüberwachung per Cloud

Ein Beispiel für eine Fernüberwachung auf Basis eines technischen Cloud-Systems hat der weltweit operierende Druckmaschinenhersteller Heidelberg zur Überwachung der Produktqualität aufgebaut. Ein wesentlicher Erfolgsfaktor von Druckmaschinen ist die präzise Fertigung von Druckwalzen. Das Schleifen der Zylinderoberfläche als abschließendes Fertigungsverfahren stellt eine große Herausforderung dar, weil neben den üblichen Anforderungen an Form- und Maßhaltigkeit auch optische Anforderungen an die Oberfläche über die Akzeptanz der Bauteile im folgenden Beschichtungs- und Montageschritt entscheiden. Die 100-%-Prüfung der optischen Oberflächenbeschaffenheit erfolgt dabei heute in einem nachgelagerten Prozessschritt außerhalb der Maschinen unter Spezialbeleuchtung. Dies hat zur Folge, dass Veränderungen im Gesamtprozess ‚Werkstück, Schleifscheibe und Werkzeugmaschine‘ nur mit zeitlicher Verzögerung entdeckt werden können. Des Weiteren treten die Veränderungen des Prozesses vielfach schleichend auf, so dass zwar im Nachgang bei einer Rückwärtsverfolgung der Serie der Ausgangspunkt der Veränderung beziehungsweise das Überschreiten eines Grenzwertes ermittelt werden können, dann jedoch eine Nacharbeit von mehreren Druckwalzen erforderlich ist.

Eine wesentliche Zielgröße bei der optischen Beurteilung der Zylinderoberfläche sind ‚Rattermarken‘ – mit dem bloßen Auge kaum wahrnehmbare Welligkeiten auf der Oberfläche. Die Ursache hierfür kann neben den unmittelbaren Zerspanungsparametern wie Schnittgeschwindigkeit, Vorschub und Schleifscheibendurchmesser auch und im Besonderen in einer der Maschinenkomponenten liegen. Das Auftreten der Rattermarken und insbesondere deren Ursache sind ohne geeignete Überwachung nicht zeitlich vorhersehbar. Beim Auftreten muss dann aber sofort reagiert werden, um den Fehler einzugrenzen und die Nacharbeit zu minimieren beziehungsweise die Erregerquelle auszuschalten und die Störung zu beheben.

Im Rahmen eines von der EU geförderten Projektes wurden der Schleifprozess von Stahlzylindern auf einer Schaudt-Polygon-Schleifmaschine durch ein Expertenteam aus Forschung, Instandhaltung und Betreiber analysiert und eine Prozessüberwachung entwickelt, die im laufenden Betrieb hauptzeitparallel die Veränderungen im Gesamtsystem aufzeichnet und bewertet – und auf diese Weise ein frühzeitiges Eingreifen ermöglicht. Die verwendete Sensorik zur Zustandsbewertung der Maschinenkomponenten und des Prozesses sind Beschleunigungsaufnehmer. Da der Entstehungsort der für die Rattermarken verursachenden Schwingungen im Vorfeld nicht bekannt ist, wurden 3-achsige Sensoren auf den Maschinenkomponenten Spindelkasten, Werkstückspindel und Reitstock sowie ein 1-achsiger Sensor auf dem Maschinenbett montiert. Zur ortsauflösenden Bestimmung der Schwingungen werden zusätzlich die Maschinenkoordinaten aufgezeichnet. Bei einer Abtastrate von 12,5 kHz und einer Auflösung von 16 bit für die Beschleunigungssensoren entstehen auf diese Weise pro Zerspanungsstunde an einer Maschine rund 1 GB an Rohdaten. Eine Speicherung und ein Datentransfer dieser Rohdaten zu einem nicht vor Ort sitzenden Experten, der die Daten analysieren kann, wären ineffizient und würden einen hohen Zeitaufwand bedeuten. Die in dem EU-Projekt untersuchte Maschine war in einem Werk in Deutschland installiert, der für die Datenanalyse zuständige Experte saß in Irland [7]. Die Idee zur Fernüberwachung durch einen ortsfernen Experten basiert auf einer bereits in der Maschine implementierten Datenvorverarbeitung, welche die Daten in Informationen überführt und somit auf eine netzwerkgeeignete Größe reduziert.

Hierzu wurde in der Schleifmaschine ein CompactRIO-System mit FPGA-Chip installiert, auf das der Experte außerhalb des Produktionswerks Zugriff hat. Auf diese Weise ist eine Anpassung der Datenanalyse durch den Experten möglich. Die durch die Analyse gewonnenen Informationen werden durch das System auf einem FTP-Server abgelegt und auf einem Analysemonitor (Bild 7) ausgegeben. Um die Anwendungsmöglichkeiten auf die Shopfloor-Ebene zu erweitern, wurde zudem an der Maschine ein Display installiert. Auf diesem kann der Experte ausgewählte Informationen in Echtzeit anzeigen lassen, die dann direkt dem Maschinenbediener zur Verfügung stehen.

Modellbasierte Prozessregelung beim Biegen

Eines der häufigsten Probleme bei der Herstellung metallischer Bauteile ist die reproduzierbare Fertigung geometrischer Formen. Formabweichungen können dabei beispielsweise durch variierende Eigenschaften der Halbzeuge oder durch Verschleiß der Werkzeuge entstehen. Üblicherweise werden die Prozessparameter auf Basis von Produktionsszenarien oder auf Basis von vergangenen Abweichungen von Soll-Ist-Vergleichen manuell eingestellt. Die Wahl neuer Parameter hängt dann meist von der Erfahrung des Maschinenbedieners ab. Dies führt zu einem langwierigen und teuren Prozess, welcher in allen Phasen des Prozesslebenszyklus auftritt. Zudem führt der allgemeine Trend zur Miniaturisierung und zur Verringerung von Toleranzen bei gleichzeitig wachsender Materialfestigkeit zu einer weiteren Erhöhung der Prozessanforderungen.

Um die Ausschussrate und die Rüstzeiten in der Produktion zu reduzieren, wurde ein modellbasierter Ansatz für eine sich selbst anpassende Steuerungsstrategie gewählt. Hierzu wird der Produktionsprozess – als Beispiel sei abschließend die Selbstoptimierung eines Biegeprozesses geschildert (Bild 8) – zunächst modelliert. In einem ersten Schritt wird der Biegeprozess durch Variierung der Prozessvariablen analysiert, die den Prozess am stärksten beeinflussen. Dies wird mit Simulationen realisiert. Anschließend werden die Korrelation zwischen den signifikanten Variablen und der geometrischen Abweichung bestimmt und verschiedene selbstoptimierende Steuerungsstrategien entwickelt und getestet. Um die Simulation zu validieren und die Qualität der selbstoptimierenden Steuerungsstrategie zu testen, wurde ein spezielles Werkzeug entwickelt. Dieses Werkzeug verfügt über eine zusätzliche Messvorrichtung und kann auf universellen Testmaschinen benutzt werden. Beim Test der selbstoptimierenden Steuerungsstrategien unter realen Produktionsbedingungen konnte der hier interessierende Prozessparameter, das Öffnungsmaß des Biegeprodukts, vollständig innerhalb der Toleranzen gehalten werden, so dass eine Ausschussrate von 0 % erreicht wurde [8]. co

Literatur

[1] Kratz, S.: Position-Oriented Vibration Monitoring of Finish Milling Thin-Walled Components; Dissertation, RWTH Aachen, Aprimus-Verlag, Aachen, ISBN-13: 978-3-86359-015-4, 2011.

[2] Pazienza, G.E.; Ponce-García, X.; Balsi, M. et al.: Robot vision with cellular neural networks: A practical implementation of new algorithms; Int. J. Circ. Theor. Appl. No. 35, pp. 449-462, 2007.

[3] Alba, L.; Domínguez Castro, R.; Jiménez-Garrido, F. et al.: New Visual Sensors and Processors; In: P. Arena, L. Patanè: Spatial Temporal Patterns; Springer, Berlin Heidelberg, pp. 351-369, 2009.

[4] Abt, F.; Heider, A.; Weber, R. et al.: Camera Based Closed Loop Control for Partial Penetration Welding of Overlap Joints; Physics Procedia, No. 12, pp. 730-738, 2011.

[5] National Instruments: Technologieausblick 2013 – Datenerfassung: Maßgebliche Trends bei Hard- und Softwaretechnologien und ihr Einfluss auf die Datenerfassung; München, 2013.

[6] Klocke, F.; Veselovac, D.; Keitzel, G.: Cloudbasierte Informationssysteme; wt-online, Ausgabe 2, SONDERHEFT INDUSTRIE 4.0, S. 090-095, 2013.

[7] Morgan, J.; Eisenblätter, G.; Trostel, J.; O’Donnell, G.E.: Machine tool process monitoring and machine condition monitoring – examining data acquisition gateways for process adaption; Proceedings of the 29th International Manufacturing Conference, University of Ulster, Belfast, Northern Ireland, ISBN-13:978-1-85923-253-8, 20122.

[8] Damerow, U.; Borzykh, M.; Homberg, W.; Trächtler, A.: A self-correcting approach for the bending of metal parts; Key Engineering Materials (KEM), Vols. 504-506, pp 907-912, 2012.

Teilen: