Edge Computing ist eines der zurzeit vieldiskutierten Themen in der Automatisierung. Aufgabe ist es, mittels Datenaggregation bereits an der Maschine aussagefähige Informationen zu nutzen oder an eine Public- oder Private-Cloud zu liefern. Alternativ werden häufig unzählige IoT-Sensor-Rohdaten in die Cloud gesendet, um die Möglichkeiten der IT zu nutzen. In Zukunft könnte Künstliche Intelligenz (KI) bereits an der Edge dazu beitragen, die Prozesse im Feld effizienter zu gestalten.

Die Fragen stellte Andreas Gees, stv. Chefredakteur KEM Konstruktion

KEM Konstruktion: Die bisher angebotenen Edge-Computing-Lösungen adressieren meist nur die Connectivity zu Servern einschließlich einer einfachen Datenvisualisierung sowie einer möglichen anschließenden intelligenten Auswertung in den Clouds führender IT-Unternehmen. Wo endet Connectivity und wo beginnt KI an der Edge oder beim Fog Computing?

Maximilian Fischer (Actyx): Das stimmt, die wirkliche Power der Edge wird überhaupt nicht genutzt. Der eigentliche Nutzen der Edge ist es, direkt Entscheidungen zu treffen, um Prozesse zu steuern. Im Kontext der Fabrik sind das Entscheidungen wie ‚Wen informiere ich, dass Komponente XYZ gleich kaputt geht?‘ oder ‚Wie muss ich meine Maschinenparameter justieren, um den optimalen Output zu erreichen?‘ Fog Computing ist dabei interessant, weil häufig eine zuverlässige Kommunikation unter den Geräten erforderlich ist. So braucht eine Maschine z.B Informationen einer anderen Qualitätsmaschine, um seine Parameter zu justieren. Idealerweise sprechen die Geräte direkt, also peer-to-peer miteinander, da man dann keinen zentralen Server mehr braucht.

Dr. Jan Jenke (Wago): Die Grenzen zwischen Cloud, Edge, Fog und den Controllern und Sensoren ergeben sich durch den Aufbau der Netzwerkinfrastruktur. Durch die kontinuierliche Leistungssteigerung der Hardware im Edge-Bereich aber auch im Embedded-Bereich lassen sich viele KI-Algorithmen dorthin verlagern. Heutzutage entscheidet daher vor allem der Use-Case darüber, ob KI in der Cloud, in der Edge, im Controller oder sogar direkt in Form eines intelligenten Sensors genutzt wird. Dazu hat nicht nur die Entwicklung im Hardware-Bereich beitragen, sondern auch entscheidende Entwicklungen in der Software.

Bild: Wago

Ein Beispiel ist die Containerisierung, die eine Abstrahierung zwischen Hardware und Software ermöglicht. Dadurch können generische KI-Funktionen entwickelt werden, die abhängig vom Use-Case in die einzelnen Ebenen aber auch Ebenen übergreifend verteilt werden. Heutzutage entscheidet die zu akzeptierende Latenz durch die Netzkommunikation darüber, wie nah der KI-Algorithmus an den Datenlieferanten ausgeführt werden muss. Entwicklungen wie 5G oder TSN werden dieses Kriterium ebenfalls in den Hintergrund rücken.

Klaus-Dieter Walter (SSV Software Systems): KI an der Edge bedeutet für mich, dass zum Beispiel die Inferenzphase eines Machine-Learning-Modells direkt an einer Sensordatenquelle oder in unmittelbarer Nähe stattfindet, also beispielsweise auf dem Edge-Gateway. Stellen wir uns hierfür einfach einen IoT-Sensor an einer Werkzeugmaschine vor, der mit 10 kHz fortlaufend Vibrationsdaten erzeugt, aus denen Informationen zum Werkzeugverschleiß gewonnen werden sollen. Anhand dieser Informationen, die per Sensordatenanalyse aus den Daten entstehen, soll die Maschine automatisch angehalten werden, bevor ein defektes Werkzeug kostspielige Schäden am Werkstück und an der Maschine verursacht. Erfolgt die Sensordatenanalyse zur Werkzeugzustandsklassifizierung und daraus abgeleitete automatisierte Entscheidungsfindung per Machine-Learning-Inferenz direkt in der OT-Ebene, haben wir es mit echter Edge-KI zu tun. Die Edge-Connectivity in die IT-Welt spielt dann nur noch eine Nebenrolle.

KEM Konstruktion: Neben Datenerfassung und Verknüpfung von Datenpunkten über diverse Schnittstellen kommt als Aufgabe die intelligente Auswertung von Daten hinzu. So basiert die Analyse des Schwingungsverhaltens von Antrieben heute beispielsweise auf regelbasierten Algorithmen. Welche Möglichkeiten stehen den Anwendern damit zur Verfügung und wo liegen die Grenzen solcher Lösungen, die zuvor in Testaufbauten ermittelt wurden?

Nikolai Falke (Wago): Die Aufstellung von regelbasierten Algorithmen wird durch die direkte Integration von Expertenwissen ermöglicht. Oft können konkrete Schwellwerte jedoch nur abgeschätzt oder unter Laborbedingungen ermittelt werden. Im Realbetrieb ist dann aber mit Abweichungen zu rechnen, die jedoch nur im besten Fall durch eine Kalibrierung des regelbasierten Systems aufgefangen werden können. Deshalb haben regelbasierte Verfahren ihre Stärken bei überschaubaren Maschinen oder Anlagen, die geringen Veränderungen unterworfen sind.

Bild: Wago

Die Komplexität der regelbasierten Verfahren steigt mit der Vielschichtigkeit des zu analysierenden Systems. Es verwundert daher nicht, dass eine häufige Anfrage von Kunden bei Wago Analytics dadurch motiviert ist, dass die Aufstellung eines regelbasierten Systems für den Anwendungsfall nicht zufriedenstellend war.

Fischer: Regelbasierte Algorithmen sind nachvollziehbar und transparent und für einfache Anwendungsfälle gut geeignet. So lassen sich nach gewissen Regeln zum Beispiel Maschinenparameter nachjustieren, um Qualität oder Ausbringungsmenge zu steigern. Diese Algorithmik kommt aber bei komplexeren Zusammenhängen an ihre Grenzen. Predictive Maintenance als Beispiel ist zwar ein großer Trend und bietet einen hohen Mehrwert. Die Übertragbarkeit der Algorithmik vom Labor in die Praxis oder sogar zwischen Maschinen gleichen Typs in der Produktion ist aber sehr herausfordernd und erfordert teilweise immer wieder Anpassungen. Hier wird es in der Zukunft durch neue Machine Learning- und KI-Ansätze einfacher werden, komplexere Zusammenhänge zu analysieren und mit größeren Schwankungen mit Realdaten umzugehen.

Walter: Regelbasierte Algorithmen sind aus meiner Sicht eine sehr unflexible und häufig auch ungenaue Angelegenheit. Sie werden aus Expertenwissen abgeleitet und von einem Softwareentwickler als Algorithmus codiert. Ein entscheidender Aspekt ist hier zunächst einmal, wie das Expertenwissen zustande gekommen ist. Ein Antriebstestaufbau ist sicherlich eine suboptimale Voraussetzung. Häufig werden dann Regeln für Schwingungsdaten aufgestellt, die mit Toleranzbändern oder anderen Schwellwerten arbeiten. Da sich Antriebselemente des gleichen Typs auf Grund der zahlreichen Einflussgrößen in jeder einzelnen Installation immer anders verhalten werden, sind die Ergebnisse mit regelbasierten Algorithmen vielfach nicht besonders hochwertig. Man müsste eigentlich für jeden Antriebsstandort eigene Regeln bilden und entsprechend codieren. Das ist aber in vielen Fällen auf Grund der damit verbundenen Kosten nicht möglich.

KEM Konstruktion: Ist es denkbar, dass über regelbasierte Lösungen hinaus künftig KI/AI mittels Neuronaler Netze erheblich mehr Anwendungsszenarien unterstützt? Was ist aus Ihrer Sicht hier ‚on the edge‘ machbar? Bislang kommt ähnliches nur in Smart-Vision-Applikationen an der Edge zum Einsatz.

Fischer: Ja, es werden in der Zukunft erheblich mehr Anwendungsfälle unterstützt werden. Einerseits wird die Hardware leistungsfähiger, andererseits werden die Modelle effizienter. Dadurch ist es möglich, nicht nur Daten einer einzelnen Maschine zu optimieren, sondern den gesamten Wertstrom zu betrachten. In Zukunft werden sich Fabriken entlang des gesamten Prozesses automatisch selbst optimieren und justieren. Maschinen kommunizieren untereinander, berechnen optimale Maschinenparameter oder finden sogar automatisch die richtigen Einstellungen für neue Produkte. Der Materialfluss ist durch fahrerlose Transportfahrzeuge optimal auf die Produktion abgestimmt und Wartezeiten werden auf ein absolutes Minimum reduziert. Mehr und mehr wird dieser Algorithmus lokal on-the-edge ausgeführt werden.

Jenke: Machine-Learning und insbesondere der Einsatz neuronaler Netze hält aktuell in verschiedenen Bereichen Einzug. Die neuen Edge-Geräte von Wago ermöglichen beispielsweise vielfältige Verfahren zur intelligenten Datenanalyse. Neuronale Netze werden dazu verwendet, Muster im zeitlichen Verlauf von Sensordaten zu erkennen. Diese Muster geben Aufschluss über bestimmte Zustände oder Fehlerfälle, die in der Maschine oder Anlage auftreten können. Dieser Anwendungsfall ist vergleichbar mit einer Vision-Applikation, in der es darum geht, Personen oder Objekte in Bildern zu erkennen. Durch die hohe Varianz in den Eingangsdaten wäre hier der Aufwand für ein regelbasiertes System sehr hoch. Neuronale Netze haben den Vorteil, dass sie perfekt dafür geeignet sind, diese Datenvielfalt abzubilden und so die Regeln selbstständig zu erlernen. Im Rahmen der Automatisierungstechnik sind jedoch deutlich mehr Potentiale für den Einsatz von KI und Machine-Learning vorhanden. Diese liegen beispielsweise in der Optimierung von Stellgrößen, der Reduzierung von Stillständen sowie der Minimierung von Qualitäts- und Prozessschwankungen. Neben den neuronalen Netzen werden hier weitere KI-Algorithmen verwendet. Durch individuelle Ansätze ist eine Integration von Expertenwissen in die KI-Algorithmen ebenfalls möglich.

Walter: Auf jeden Fall eignen sich die KI und speziell künstliche neuronale Netzwerke aus dem Umfeld des maschinellen Lernens für deutlich mehr Anwendungsszenarien als regelbasierte Lösungen. Schauen Sie sich bitte den aktuellen Stand der Technik im Machine-Vision-Bereich an. Objekterkennung und Segmentierung in hochauflösenden Bilddaten bekommt man in der inzwischen im Praxiseinsatz befindlichen Qualität nur über entsprechend trainierte neuronale Netzwerke hin.

Bild: SSV Software Systems

Mit regelbasierten Algorithmen sind solche Ergebnisse meines Erachtens überhaupt nicht möglich. In Bezug auf die Wissensnutzung mit neuronalen Netzen, also der Inferenz, halte ich alles, was wir heute in der Cloud können, technisch auch an der Edge für möglich. Die Cloud bleibt allerdings die ideale Umgebung für die Modellbildung. Neben Smart Vision werden wir in nächster Zeit auf jeden Fall zahlreiche weitere KI-Anwendungen an der Edge sehen. Dazu gehören sicherlich auch Cobot-Sprachsteuerungen und die automatisierte Entscheidungsfindung anhand von Echtzeitdaten für mobile Roboter in der Intralogistik einer Smart Factory.

KEM Konstruktion: Welche Bedeutung wird zukünftig spezielle Hardware auf der Basis von Halbleiter-Chips für das KI-Edge-Computing erlangen, wie sie von Intel, Xilinx oder Nvidia angeboten werden? Legen solche SoCs die Basis für smarte Lösungsangebote?

Falke: Die aktuellen Entwicklungen bei der Hardwareunterstützung von KI-Algorithmen sind als sehr positiv zu betrachten. Diese spezialisierte Hardware ermöglicht es, die Datenanalyse weiter in Richtung der Datenquellen zu verschieben. So lassen sich spezielle KI-Anwendungsfälle schon direkt an der Datenquelle realisieren. Hier ist man sicherlich noch am Anfang einer spannenden Entwicklung, sodass gerade für eine dynamische Anwendung von KI der Einsatz von leistungsfähiger Hardware an der Edge oder die Nutzung der Cloud weiterhin attraktiver wird.

Fischer: Diese Entwicklung ist ein wichtiger Treiber für ML/KI-Anwendungen. Neue Hardwarechips ermöglichen es, immer komplexere und aufwendigere Modelle in der Cloud in kürzerer Zeit zu trainieren. Die gesteigerte Effizienz der neuen Chips ermöglicht es aber auch, mehr Logik on-the-edge auszuführen.

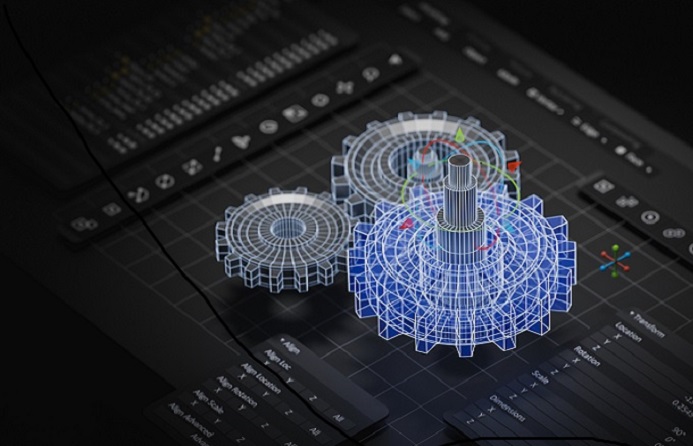

Bild: Actyx

Am Ende basiert KI auf aufwendigen Rechenmodellen, und wenn diese Berechnungen schneller durchgeführt werden können, ergeben sich auch neue Möglichkeiten. Smartphones beispielsweise wurden auch erst durch eine enorme Verbesserung der Hardware ermöglicht.

Walter: Die Bedeutung wird weiter zunehmen. Da sich in der KI die künstlichen neuronalen Netzwerke durchsetzen und diese Netze besonders bei Deep-Learning-Anwendungen sehr rechenintensiv sind, steigt der Bedarf an geeigneter Hardwareunterstützung. Allerdings nicht nur im High-End-Bereich, also bei den universellen FPGAs bzw. den Spezialarchitekturen von Nvidia, Google u.a., sondern auch bei den Mikrocontrollern im Low-Cost-Segment. Gerade hier sind in den kommenden Jahren die meisten Innovationen zu erwarten, was für die Chiphersteller riesige Stückzahlen bedeuten würde. Chips mit integrierten KI-Beschleunigern sollen letztendlich auch in batteriebetriebenen Geräten zum Einsatz kommen, beispielsweise für eine wirklich intelligente Sensorik. Vielleicht werden mit Hilfe solcher Chipinnovationen die vielen Dinge, die seit Jahren das Label ‚Smart‘ tragen, demnächst tatsächlich intelligent.

KEM Konstruktion: Aufbauend auf der letzten Frage interessiert uns zudem, wie weit am Ende dann Edge-Devices mit PC-basierter Steuerungstechnik verschmelzen, um die Vorteile der KI in Echtzeit direkt im Prozess nutzen zu können?

Fischer: Das ist eine berechtigte Frage, und das ist ein Trend, den man jetzt schon sehen kann. Praktisch alle Steuerungsanbieter gehen den Weg, auf der SPS mehr und mehr Intelligenz durch komplexere Software zu ermöglichen. Diese ist noch relativ stark getrennt von der eigentlichen Automatisierungswelt. In Zukunft werden diese beiden Welten mehr und mehr miteinander verschmelzen. Für sicherheitsrelevante Aspekte ist die klassische Steuerungstechnik derzeit nicht wegzudenken, wer weiß aber, welche neuen Ansätze sich zukünftig noch entwickeln werden. Die Welt verändert sich immer schneller und KI wird fraglos in praktisch allen Aspekten unseres Lebens eine enorme Bedeutung erlangen.

Jenke: Die Verschmelzung von Edge-Computing und Steuerungstechnik ist erstrebenswert. Sobald KI intensiver genutzt wird, wird automatisch mehr Rechenleistung benötigt. Aus ökonomischer Sicht ist es insbesondere in einem dynamischen Umfeld sinnvoll, diese in die Edge auszulagern, um nicht in teure Steuerungstechnik mit ungenutzter Rechenleistung zu investieren. Dazu ist ein dynamisches Deployment von Software nötig, welches nicht zuletzt durch die Container-Technologie ermöglicht wird.

Walter: Das ist eine sehr schwierige Frage. Meiner Meinung wird die gute alte PC-Architektur mit ihren x86-Plattformen dieses Jahrzehnt nicht überleben. Offensichtlich sehen ja selbst die x86-Chip-Anbieter – also Intel und AMD – keine allzu große Zukunft für ihre bisherige Technik. Warum sonst kaufen beide relativ kurz hintereinander jeweils einen marktrelevanten FPGA-Anbieter? Insofern ist für mich die PC-basierte Steuerungstechnik in ihrer letzten, vielleicht vorletzten Lebensphase angekommen. Zukunftsfähige und zukünftige Konzepte basieren auf ARM und RISC-V. In der Gegenwart und den nächsten paar Jahren wird es allerdings eine Verschmelzung geben – erste Produkte existieren ja bereits. Sie nutzen einen ‚KI-Erweiterungssteckplatz‘, in dem zum Beispiel bei Bedarf ein Edge-TPU-Modul – also eine Tensor Processing Unit im Modulformat – eingesteckt wird.

www.actyx.com

www.ssv-embedded.de

www.wago.com